w I-LO w Tarnowie

Materiały dla uczniów liceum

Wyjście Spis treści Wstecz Dalej

Autor artykułu: mgr Jerzy Wałaszek

©2026 mgr Jerzy Wałaszek

|

Serwis Edukacyjny w I-LO w Tarnowie

Materiały dla uczniów liceum |

Wyjście Spis treści Wstecz Dalej

Autor artykułu: mgr Jerzy Wałaszek |

©2026 mgr Jerzy Wałaszek

|

Na początku wyjaśnimy sobie kilka spraw. Pierwsza z nich dotyczy komputera. Czym jest komputer? Skąd się wziął, jak doszło do jego powstania?

Współczesny komputer może posiadać różny wygląd i przeznaczenie:

|

|

|

| Komputer biurkowy | Tablet | Smartfon |

|

|

|

| TVbox | Digispark | Konsola do gier |

|

|

|

| Drukarka | Smart TV | Aparat cyfrowy |

|

|

|

| Kamera cyfrowa | Nawigacja GPS | Syntezator |

Pomimo różnego wyglądu oraz funkcji, współczesne komputery posiadają wspólne składniki. Do czego służą komputery? Nazwa komputer pochodzi od słowa angielskiego "computer". Jeszcze przed II wojną światową słowo to oznaczało zawód rachmistrza, czyli osoby, która zawodowo wykonywała obliczenia. Pierwsze komputery faktycznie zajmowały się tylko obliczeniami, dlatego przypisano im taką właśnie nazwę.

Ogólniej, komputer jest urządzeniem, które służy do przetwarzania informacji. Co to znaczy przetwarzać informację? Aby odpowiedzieć na to pytanie musimy najpierw wyjaśnić, czym jest informacja. Wbrew pozorom nie jest to wcale takie proste. Od tego, co wybierzemy za informację, zależy budowa całego komputera. Pierwsze komputery pracowały na liczbach. Zatem informacją były tutaj cyfry tworzące liczbę oraz działania, które należało na tych liczbach wykonać. Na przykład, wprowadzamy do komputera dwie liczby 5 i 7 oraz działanie, które ma nad tymi liczbami zostać wykonane "x":

Komputer "przetwarza" tę informację i wyprowadza wynik 35, który jest przetworzoną informacją. Zatem "przetwarzanie" informacji polega na odpowiednim przekształcaniu informacji wejściowej w pożądaną informację wyjściową.

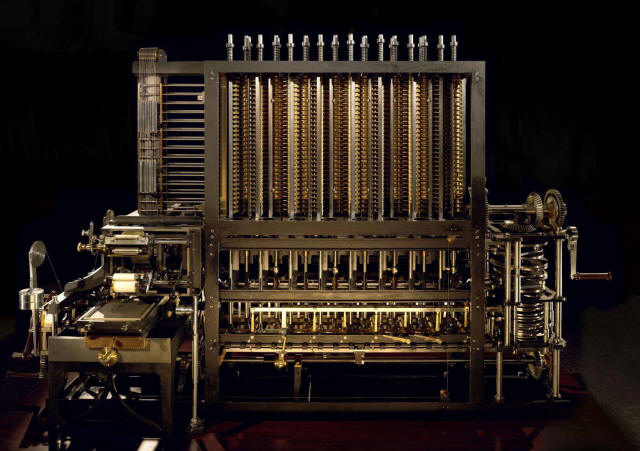

Pozostaje jeszcze jeden problem do rozwiązania: jaką postać ma przybierać informacja, którą komputer będzie przetwarzał? Pierwsze maszyny liczące operowały na liczbach. Jako przykład możemy podać sławną maszynę różnicową, zaprojektowaną przez Charlesa Babbage'a w połowie XIX wieku:

Maszyny tej nigdy nie ukończył, prototyp zbudowano dopiero w końcu XX wieku.

Jednakże cyfry nie są wygodną postacią informacji, ponieważ wymagają skomplikowanych operacji przy ich przetwarzaniu. Okazało się, że najbardziej właściwą postacią informacji dla komputerów są tzw. bity. Słowo bit wymyślił informatyk amerykański John Turkey w latach 40-tych XX wieku. Jest to połączenie dwóch słów angielskich:

binary + digit

binarna cyfra

Czym jest bit? Jest to ogólnie taka informacja, która może przybierać tylko 2 różne postacie. Na przykład:

W informatyce do zapisu bitów używa się dwóch cyfr 0 i 1. Tak można się bawić na papierze. Jeśli chcemy przetwarzać bity za pomocą maszyny, to musimy im nadać taką postać, która będzie łatwa do przetworzenia w tej maszynie (komputerze). Tutaj istnieje praktycznie nieskończona liczba możliwości. Bity mogą być reprezentowane za pomocą prądu elektrycznego, napięcia elektrycznego, wiązki światła, fali akustycznej, fali elektromagnetycznej itp. We współczesnych komputerach bity są reprezentowane za pomocą napięć elektrycznych, ponieważ komputery są urządzeniami elektrycznymi. Ale nie zawsze tak było. Pierwszy komputer przetwarzający bity skonstruował niemiecki inżynier Konrad Zuse w roku 1936. Był to komputer mechaniczny:

Konrad Zuse za zrekonstruowanym komputerem mechanicznym Z1

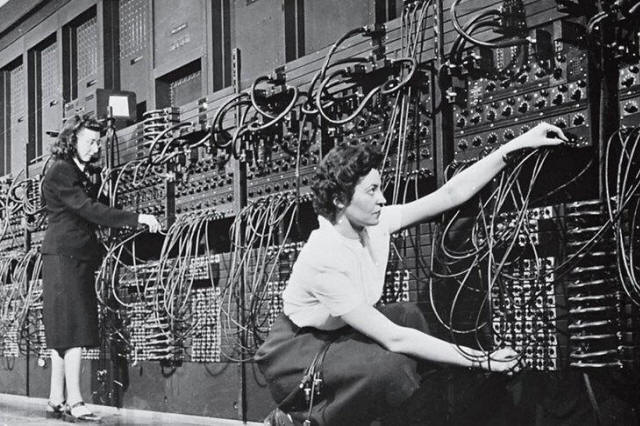

Komputer ENIAC z roku 1945

Postęp w konstrukcji komputerów był bardzo szybki wraz z rozwojem elektroniki. W roku 1951 powstał komercyjny komputer UNIVAC przetwarzający bity.

Komputer UNIVAC z roku 1951

Wyjaśnijmy teraz, jak za pomocą bitów można przetwarzać informację. Ludzie do przekazywania informacji wykorzystują język w postaci mówionej lub jako pismo. Język zawiera słowa oraz reguły gramatyczne, które określają sposób używania tych słów, łączenia ich w zdania, odmiany, itp. Ważne jest to, iż sowo same w sobie nie reprezentuje żadnej informacji. Kiedyś, w zamierzchłej przeszłości nasi przodkowie wypracowali znaczenia słów, które zmieniały się z upływem czasu, aż powstał język. Przypisywanie informacji słowom staje się oczywiste, gdy uczymy się obcego języka. Musimy wtedy poznać, co dane słowo oznacza i jak należy go używać z innymi słowami. Gdyby słowa przenosiły informację same w sobie, nie musielibyśmy się tego uczyć, niestety, tak dobrze nie ma - inny język, inne słowa lub inne znaczenia tych samych słów. Na przykład w języku rosyjskim lustro, to żyrandol, a zapomnieć znaczy zapamiętać.

Co z tego wynika. Przyjmij, że słowa są jakby pojemnikami, w których umieszczamy informację, gdy nadajemy słowu znaczenie. Następnie taki pojemnik przekazujemy innej osobie i jeśli ta osoba zna znaczenie słowa (czyli zawartość pojemnika), to odbierze przekazaną informację. U nas odbywa się to automatycznie, mówimy, że rozumiemy słowa.

Ciekawe w tym jest to, iż słowa można rozszerzyć na dowolne symbole, np. na bity. Jeśli nadamy im znaczenia, to otrzymamy język bitowy, w którym będziemy mogli przekazywać informację. Załóżmy, że posiadasz latarkę z dwoma filtrami: czerwonym i zielonym:

Latarki tego typu posiadają dwa suwaki, które nasuwają na żarówkę filtr odpowiedniego koloru, latarka może zatem świecić na czerwono, zielono lub na biało (bez filtrów). Załóżmy, że z kolegą mieszkającym w bloku naprzeciwko umówiliście się, że będziecie sobie przekazywać informację błyskami latarek o tym, czy w domu są rodzice (światło czerwone), czy ich nie ma (światło zielone). Światło białe pomijamy. Ponieważ mamy tutaj tylko dwie różne postacie światła, możemy mówić o bicie informacji:

| Bit | Znaczenie |

| Światło czerwone | Rodzice w domu, z imprezy nici |

| Światło zielone | Rodziców nie ma, impreza!!! |

Powstał w ten sposób prymitywny język, niemniej użyteczny w pewnych sytuacjach. Język ten składa się z dwóch słów i jest utworzony na podstawie jednego bitu. Wiele czujników stosuje takie jednobitowe języki. Np. czujnik przeciwpożarowy w razie wzrostu temperatury w chronionym pomieszczeniu zwiera styki i w połączonym z tym czujnikiem obwodzie elektrycznym zaczyna płynąć prąd (lub przestaje płynąć, jeśli styki są rozwierane - ta wersja jest nawet lepsza pod względem bezpieczeństwa). Prąd w obwodzie włącza alarm. Znów mamy do czynienia z bitem informacyjnym, ponieważ sygnał ma dwie postacie:

| Bit | Znaczenie |

| Brak prądu w obwodzie | Nie ma pożaru |

| Jest prąd w obwodzie | Wykryto pożar. ALARM!!! |

Podobnie działa czujnik ruchu, czujnik zamknięcia drzwi, czujnik zmierzchowy włączający oświetlenie nocne, itp.

Zwróć uwagę na jedną rzecz - bit nie posiada określonego znaczenia, dopóki je mu nie przypiszemy. Oznacza to, iż my określamy znaczenie bitu. Dzięki temu bit jest uniwersalnym nośnikiem informacji.

Jeden bit ma dwa różne stany, zatem można w nim zdefiniować dwie informacje, po jednej dla każdego stanu. Umówmy się teraz, że bity będziemy zapisywać za pomocą cyfr 0 i 1. W rzeczywistości 0 i 1 są reprezentowane w najprzeróżniejszy sposób.

Zapiszmy:

|

1 bit → 2 informacje 0 → jedna informacja 1 → druga informacja |

Co zrobić, jeśli mamy więcej informacji? Musimy zdobyć więcej słówek - nasz ludzki język nie składa się przecież z dwóch słów. Jak to zrobić z bitami? Odpowiedź jest prosta: należy połączyć bity ze sobą i potraktować je jak nową całość (w języku ludzkim tak powstają nowe wyrazy, przez łączenie ze sobą dźwięków spółgłosek i samogłosek).

Jeśli połączymy dwa bity, to otrzymamy 4 różne słówka bitowe:

|

00 → jedna informacja 01 → druga informacja 10 → trzecia informacja 11 → czwarta informacja 2 bity → 4 informacje |

Jak widzisz, liczba słówek wzrosła dwukrotnie, możemy zatem operować dwa razy większą liczbą informacji, czyli czterema. Teraz nasz język może być bardziej precyzyjny. Na przykład umawiasz się z kolegą, iż przekazujesz latarką z czerwonym i zielonym światłem dwa bity za pomocą dwóch błysków, które należy potraktować wspólnie. Informacje mogą być następujące:

| 2 bity | Informacja | |

| Pierwszy błysk | Drugi błysk | |

| czerwony | czerwony | W domu są oboje rodzice |

| czerwony | zielony | W domu jest ojciec, nie ma matki |

| zielony | czerwony | W domu jest matka, nie ma ojca |

| zielony | zielony | W domu nie ma rodziców, impreza!!! |

Jeśli dodasz następny bit, to liczba słówek znów wzrośnie 2 razy (dlaczego?) i otrzymasz 8 słów bitowych, które możesz wykorzystać do zakodowania 8 różnych informacji:

|

000 → jedna informacja 001 → druga informacja 010 → trzecia informacja 011 → czwarta informacja 100 → piąta informacja 101 → szósta informacja 110 → siódma informacja 111 → ósma informacja 3 bity → 8 informacji |

Im więcej bitów użyjesz w swoich słowach bitowych, tym więcej tych słów otrzymasz:

| Liczba bitów | Liczba informacji |

| 1 | 2 |

| 2 | 4 |

| 3 | 8 |

| 4 | 16 |

| 5 | 32 |

| 6 | 64 |

| 7 | 128 |

| 8 | 256 |

| 16 | 65536 |

| 32 | 4294967296 |

| 64 | 18446744073709551616 |

| n | 2n |

Liczba słówek przyrasta wykładniczo wraz ze wzrostem bitów. Co to oznacza? Otóż zawsze możemy z bitów utworzyć tyle słówek bitowych, ile jest nam potrzebne.

Zobaczmy teraz na prostych przykładach, jak można wykorzystać bity do kodowania różnych informacji.

Obraz cyfrowy jest zbudowany z siatki punktów, które nazywamy pikselami (ang. pixel = picture element). Są to niepodzielne fragmenty obrazu o jednolitym kolorze. Wyobraźmy sobie, że mamy następujący obrazek:

Aby zobaczyć strukturę tworzących go pikseli, powiększmy go:

Tabela kodów kolorów:

| – 0 | |

| – 1 |

Piksele przyjmują tutaj tylko dwa kolory: czarny i biały. Dwa kolory możemy zakodować przy pomocy jednego bitu (patrz: tabelka w poprzednim podrozdziale). Umawiamy się, że bit 0 będzie oznaczał kolor tła, czyli kolor biały, a bit 1 będzie oznaczał kolor tuszu, czyli czarny – w ten sposób określamy znaczenie słów 0 i 1 w języku grafiki tego obrazka. Jeśli każdy piksel obrazka zastąpimy kodującym go bitem, to otrzymamy następujący wynik:

00000000000000000000010000000100 00000000000000000000000000001000 00000000000000000000001000010000 00000000000000000100000000100000 00000000000011111000000000010101 00000000000100000110001110000000 00000000001000000001110000000000 00000000001000000000000000010000 00000000001000000000010010001000 00000001111111000000100000000100 00000001111111000001000010000000 00000001111111000000000000000000 00000111111111110000000010000000 00011111111111111100000000000000 00011111111111111100000000000000 00111111111111111110000000000000 00111111111111111110000000000000 01111011111111111111000000000000 01110111111111111111000000000000 01110111111111111111000000000000 01100111111111111111000000000000 01100111111111111111000000000000 01110111111111111111000000000000 01111011111111111111000000000000 00111011111111111110000000000000 00111100111111111110000000000000 00011111111111111100000000000000 00011111111111111100000000000000 00000111111111110000000000000000 00000001111111000000000000000000 |

Obrazek stał się mało czytelny dla człowieka, lecz bity są znakomicie czytelne dla komputerów. Te 0 i 1 zostaną przekształcone na odpowiednie sygnały elektryczne i układy komputera będą mogły je przechować, przetworzyć lub przesłać przez sieć informatyczną nawet na drugi koniec świata. Jeśli odbiorca będzie znał znaczenie poszczególnych bitów (będzie rozumiał język grafiki tego obrazka), to bez problemów odtworzy sobie treść.

Oczywiście piksele mogą przybierać więcej niż 2 kolory. W takim przypadku rośnie liczba informacji i należy zwiększyć ilość bitów kodujących kolor piksela. Oto ten sam obrazek z 4 kolorami pikseli:

Tabela kodów kolorów:

| – 00 | |

| – 01 | |

| – 10 | |

| – 11 |

Po zakodowaniu otrzymujemy (każde dwa bity to jeden piksel):

0000000000000000000000000000000000000000001000000000000000100000 0000000000000000000000000000000000000000000000000000000010000000 0000000000000000000000000000000000000000000010000000001000000000 0000000000000000000000000000000000100000000000000000100000000000 0000000000000000000000001111111111000000000000000000001000100010 0000000000000000000000110000000000111100000011101000000000000000 0000000000000000000011000000000000000011111100000000000000000000 0000000000000000000011000000000000000000000000000000001000000000 0000000000000000000011000000000000000000001000001000000010000000 0000000000000001010101010101000000000000100000000000000000100000 0000000000000001010101010101000000000010000000001000000000000000 0000000000000001010101010101000000000000000000000000000000000000 0000000000010101010101010101010100000000000000001000000000000000 0000000101010101010101010101010101010000000000000000000000000000 0000000101010101010101010101010101010000000000000000000000000000 0000010101010101010101010101010101010100000000000000000000000000 0000010101010101010101010101010101010100000000000000000000000000 0001010101110101010101010101010101010101000000000000000000000000 0001010111010101010101010101010101010101000000000000000000000000 0001010111010101010101010101010101010101000000000000000000000000 0001011111010101010101010101010101010101000000000000000000000000 0001011111010101010101010101010101010101000000000000000000000000 0001010111010101010101010101010101010101000000000000000000000000 0001010101110101010101010101010101010101000000000000000000000000 0000010101110101010101010101010101010100000000000000000000000000 0000010101011111010101010101010101010100000000000000000000000000 0000000101010101010101010101010101010000000000000000000000000000 0000000101010101010101010101010101010000000000000000000000000000 0000000000010101010101010101010100000000000000000000000000000000 0000000000000001010101010101000000000000000000000000000000000000 |

Zwiększając liczbę bitów na piksel, otrzymujemy możliwość kodowania coraz większej liczby kolorów. Jeśli przeznaczymy na piksele po 8 bitów, to nasze obrazki będą mogły posiadać do 28 = 256 różnych kolorów – popularny w sieci format GIF (ang. Graphics Interchange Format) stosuje właśnie takie rozwiązanie. Grafika GIF najlepiej nadaje się do rysunków, zdjęcia nie wychodzą w niej najlepiej.

Obrazek GIF

Format JPG/JPEG (ang. Joint Photographic Experts Group) pozwala kodować piksele 24 bitami. Daje to gamę 224 = 16 milionów kolorów, więcej niż potrafi rozróżnić ludzkie oko. Tryb ten nosi nazwę True Color (prawdziwy kolor) i doskonale nadaje się do cyfrowej fotografii.

Obrazek JPG

Film to nic innego jak seria szybko po sobie wyświetlanych obrazków, co daje wrażenie ruchu. Każdy z tych obrazków jest kodowany w opisany powyżej sposób.

Animowany GIF

Wniosek: bity doskonale nadają się do reprezentowania grafiki oraz filmów.

Tekst jest wciąż bardzo ważny dla ludzi i stosujemy go powszechnie. Tekst zbudowany jest ze znaków. Każdy znak potraktujemy jak osobną informację. Najpierw określamy zbiór znaków, które będziemy chcieli kodować za pomocą bitów. Na przykład tak:

Teraz liczymy, ile mamy znaków do zakodowania. Wychodzi 56 znaki. Ile potrzebujemy bitów na każdy znak? Oczywiście 6, ponieważ 26 = 64. Zatem słówka 6-bitowe pokrywają zapotrzebowanie, a nawet mamy mały zapas na przyszłe rozszerzenia.

W następnym kroku musimy każdej z liter przypisać unikalne słówko bitowe. Będziemy je nazywali kodem binarnym znaku (ang. binary character code). Możemy to zrobić tak:

A 000000 |

F 001000 |

M 010000 |

S 011000 |

Z 100000 |

5 101000 |

; 110000 |

Ą 000001 |

G 001001 |

N 010001 |

Ś 011001 |

Ż 100001 |

6 101001 |

+ 110001 |

B 000010 |

H 001010 |

Ń 010010 |

T 011010 |

Ź 100010 |

7 101010 |

- 110010 |

C 000011 |

I 001011 |

O 010011 |

U 011011 |

0 100011 |

8 101011 |

* 110011 |

Ć 000100 |

J 001100 |

Ó 010100 |

V 011100 |

1 100100 |

9 101100 |

/ 110100 |

D 000101 |

K 001101 |

P 010101 |

W 011101 |

2 100101 |

. 101101 |

( 110101 |

E 000110 |

L 001110 |

Q 010110 |

X 011110 |

3 100110 |

, 101110 |

) 110110 |

Ę 000111 |

Ł 001111 |

R 010111 |

Y 011111 |

4 100111 |

: 101111 |

110111 |

Gdy kody binarne wszystkich znaków będą gotowe, możemy przystąpić do kodowania tekstu. Każdą literkę tekstu zastępujemy odpowiadającym jej kodem binarnym. Na przykład:

JAPONIA JEST PIĘKNYM KRAJEM. J 001100 A 000000 P 010101 O 010011 N 010001 I 001011 A 000000 110111 J 001100 E 000110 S 011000 T 011010 110111 P 010101 I 001011 Ę 000111 K 001101 N 010001 Y 011111 M 010000 110111 K 001101 R 010111 A 000000 J 001100 E 000110 M 010000 . 101101 |

001100000000010101010011010001001011000000110111001100000110011000011010110111010101001011000111001101010001011111010000110111001101010111000000001100000110010000101101

Otrzymany ciąg bitów możemy dowolnie przetwarzać na komputerach.

Działanie odwrotne jest również proste. Załóżmy, że otrzymaliśmy ciąg bitów:

Ponieważ wiemy, że w naszym systemie każdy znak jest reprezentowany przez 6 bitów, to otrzymany ciąg dzielimy na grupy 6 bitowe:

Dostaliśmy kody bitowe poszczególnych znaków. Zamieniamy je na litery zgodnie z tabelą kodu:

| 000010 | 000111 | 000101 | 000111 | 110111 | 001100 | 011011 | 011010 | 010111 | 010011 | 101101 |

| B | Ę | D | Ę | spacja | J | U | T | R | O | . |

BĘDĘ JUTRO.

Powyższy kod znakowy jest tylko przykładem szkolnym. W praktyce stosuje się nieco bardziej zaawansowane rozwiązania, np. kod ASCII (ang. American Standard Code for Information Interchange), w którym kod każdego znaku jest 8-mio bitowy. Kod ASCII pozwala kodować 256 różnych znaków. Oczywiście jest to zbyt mało dla kodowania wszystkich używanych przez ludzi liter. Z tego powodu utworzono kod Unicode, gdzie znaki mogą mieć do 32 bitów długości. Kod Unicode powszechnie jest stosowany w Internecie oraz w systemie Windows. Dzięki temu obecne przeglądarki sieciowe potrafią poprawnie wyświetlać tekst praktycznie w każdym języku (pod warunkiem, że masz zainstalowaną odpowiednią czcionkę).

Wniosek: bity nadają się do kodowania znaków.

Teraz pokażemy sposób przedstawiania liczb naturalnych za pomocą bitów. Wyobraźmy sobie, iż żyjemy w takim dziwnym kraju (no, może tak bardzo tego nie musimy sobie wyobrażać, wystarczy się rozglądnąć), w którym wszystkie monety mają nominały równe potęgom liczby 2:

|

Załóżmy, iż w tym dziwnym kraju wyszło zarządzenie, które głosi, iż wszystkie kwoty należy wypłacać najmniejszą możliwą liczbą monet. Za nieprzestrzeganie tego zarządzenia rząd nałożył olbrzymią karę 264. Cóż, nikt tyle pieniążków nie miał, zatem wszyscy rozpoczęli skrupulatne odmierzanie sum pieniężnych.

Z sumami będącymi potęgami liczby 2 nie ma problemu - wystarczy jedna moneta o właściwym nominale. Pozostałe sumy wyliczamy następująco:

Trzeba wypłacić 157. Aby monet było jak najmniej, każda o właściwym nominale powinna wystąpić co najwyżej raz. Ano zobaczmy:

Pierwszą monetą może być 128 (256 byłoby za duże, a 64 musielibyśmy użyć dwukrotnie). Zatem płacimy 128. Pozostaje wciąż:

157 - 128 = 29

Najbliższą monetą będzie 16. Płacimy 16. Pozostaje:

29 - 16 = 13

Teraz płacimy 8. Pozostaje:

13 - 8 = 5

Płacimy 4. Pozostaje:

5 - 4 = 1

I na koniec wypłacamy 1. Podsumujmy:

157 = 128 + 16 + 8 + 4 + 1

No dobrze, powiesz. Co to ma jednak wspólnego z bitami? A ma. Zwróć uwagę, iż przy wypłacie sumy podejmujemy dla poszczególnych nominałów monet jedną z decyzji:

| Wypłacić daną monetę | - 1 |

| Nie wypłacać monety | - 0 |

A to są przecież nasze kochane bity. Ułóżmy monety kolejno z prawa na lewo od najmniejszej do największej. Otrzymamy następujący ciąg nominałów:

| Nominał | ... | 1024 | 512 | 256 | 128 | 64 | 32 | 16 | 8 | 4 | 2 | 1 |

| Potęga 2 | ... | 210 | 29 | 28 | 27 | 26 | 25 | 24 | 23 | 22 | 21 | 20 |

Teraz pod tak wypisanymi nominałami zapisujemy dla danej sumy pieniężnej wypłaconą liczbę monet danego nominału:

| Nominał | ... | 1024 | 512 | 256 | 128 | 64 | 32 | 16 | 8 | 4 | 2 | 1 |

| Potęga 2 | ... | 210 | 29 | 28 | 27 | 26 | 25 | 24 | 23 | 22 | 21 | 20 |

| 157 = | 0 | 0 | 0 | 1 | 0 | 0 | 1 | 1 | 1 | 0 | 1 |

Ponieważ dana moneta może wystąpić co najwyżej raz, to pod nominałami zapisujemy tylko cyfry 0 lub 1. Jeśli cyfry potraktujemy teraz jako bity, otrzymamy zapis binarny danej liczby dziesiętnej:

157(10) = ...00010011101(2)

W zapisie tym bit o stanie 1 ma wartość odpowiadającej mu potęgi liczby 2. Bit o stanie 0 ma wartość 0. Aby obliczyć wartość całej liczby binarnej wystarczy zatem zsumować wartości bitów o stanie 1.

Oto inny przykład:

W dziwnym kraju na czeku bankier wypisał sumę pieniężną zaznaczając liczbę monet o kolejnych nominałach, które należy wypłacić klientowi banku. Zrobił to tak:

1011101101

Jaką sumę należy wypłacić? My już wiemy. Skoro poszczególne cyfry oznaczają liczbę monet o danym nominale, zapisujemy to tak:

| Nominał | 512 | 256 | 128 | 64 | 32 | 16 | 8 | 4 | 2 | 1 |

| Potęga 2 | 29 | 28 | 27 | 26 | 25 | 24 | 23 | 22 | 21 | 20 |

| SUMA = | 1 | 0 | 1 | 1 | 1 | 0 | 1 | 1 | 0 | 1 |

Teraz sumujemy nominały wypłaconych monet i otrzymujemy:

512 + 128 + 64 + 32 + 8 + 4 + 1 = 749

Proste? Jeśli nie, to przeczytaj to kolejny raz, aż zrozumiesz.

Formalnie rzecz biorąc, jeśli mamy n bitową liczbę binarną:

bn-1 bn-2 ... b2 b1 b0, gdzie bi = 0 lub 1, dla i = 0,1,2,...,n-1

to jej wartość dziesiętną obliczamy zgodnie z poniższym wzorem:

wartość = bn-12n-1 + bn-22n-2 + ... + b222 + b121 + b020

Wniosek: bity nadają się do kodowania liczb.

|

Zespół Przedmiotowy Chemii-Fizyki-Informatyki w I Liceum Ogólnokształcącym im. Kazimierza Brodzińskiego w Tarnowie ul. Piłsudskiego 4 ©2026 mgr Jerzy Wałaszek |

Materiały tylko do użytku dydaktycznego. Ich kopiowanie i powielanie jest dozwolone pod warunkiem podania źródła oraz niepobierania za to pieniędzy.

Pytania proszę przesyłać na adres email:

Serwis wykorzystuje pliki cookies. Jeśli nie chcesz ich otrzymywać, zablokuj je w swojej przeglądarce.

Informacje dodatkowe.